Robots Explorent Constamment Le Web Pour Découvrir Les Pages

Salut tout le monde ! Vous êtes-vous déjà demandé comment Google ou Bing trouvent toutes ces pages web incroyables, celles qui répondent pile à votre question du moment ? C’est pas de la magie, hein. C'est grâce à de petits (enfin, pas si petits que ça !) robots numériques qui parcourent le web 24h/24, 7j/7. Imaginez-les comme des explorateurs hyperactifs, toujours à la recherche de nouveaux territoires. C'est fascinant, non ?

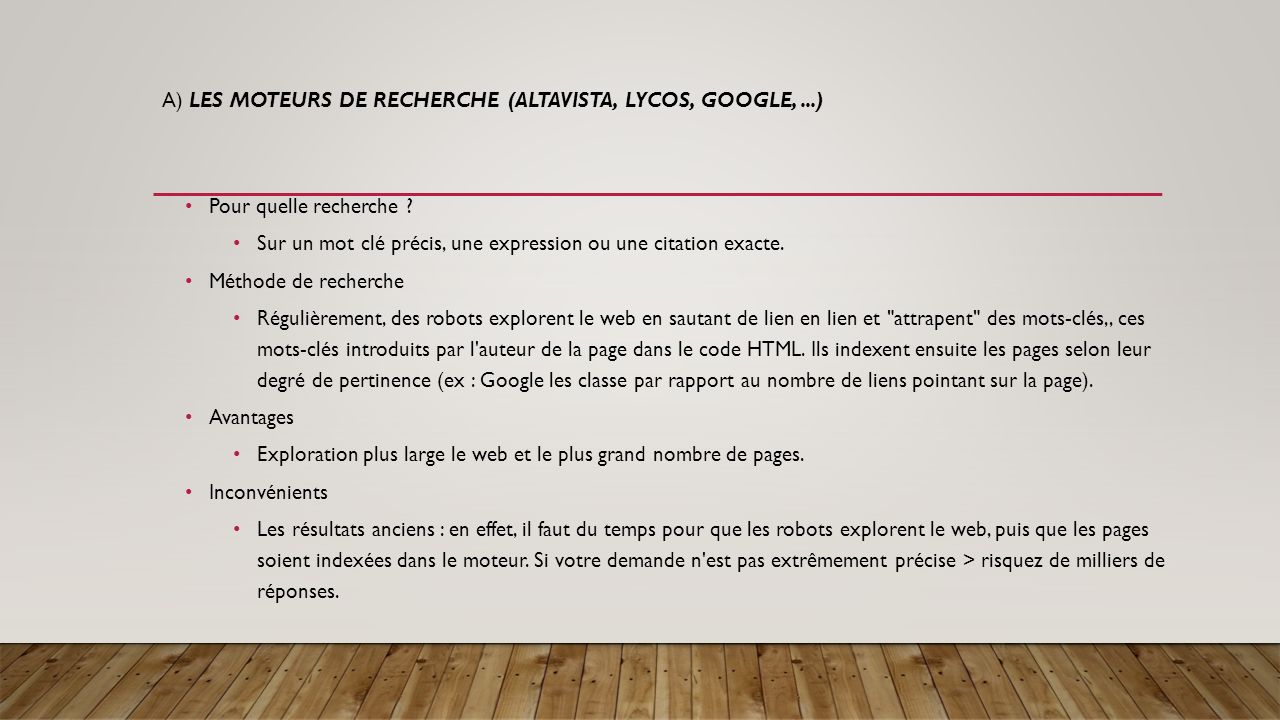

C'est quoi, ces fameux robots ?

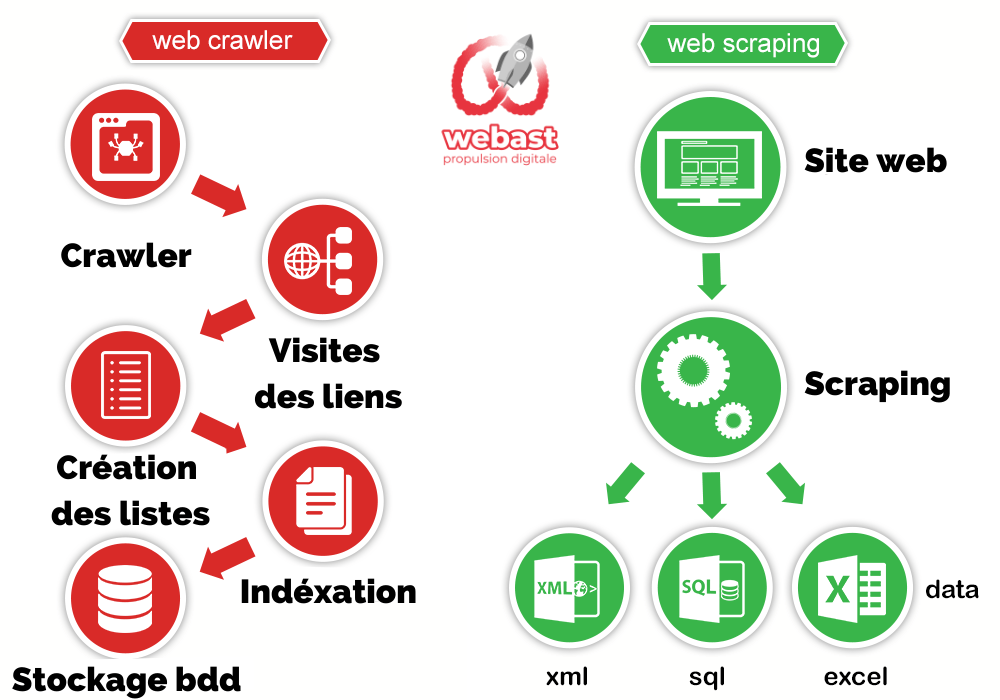

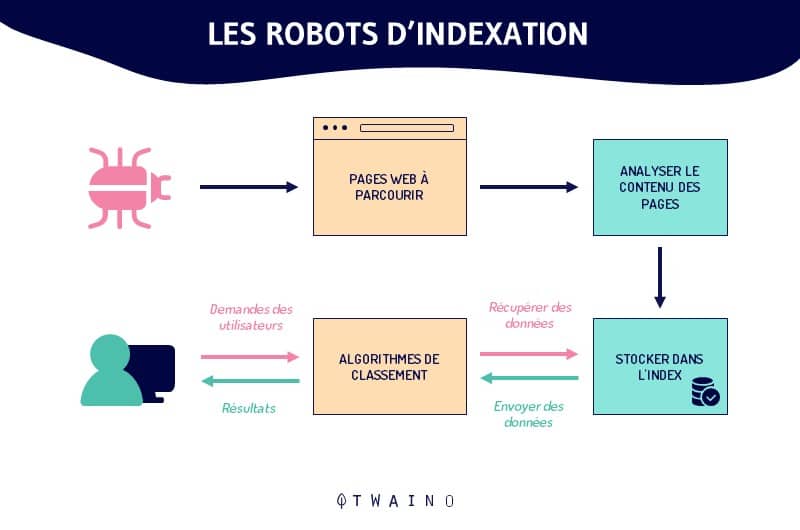

On les appelle des robots d’indexation, crawlers, spiders, ou encore bots. Le nom importe peu, l'important c'est qu'ils sont programmés pour une seule chose : découvrir et analyser le contenu des pages web. Imaginez une équipe de bibliothécaires infatigables, mais au lieu de livres, ils lisent des pages web à la vitesse de la lumière !

Comment ça marche, concrètement ?

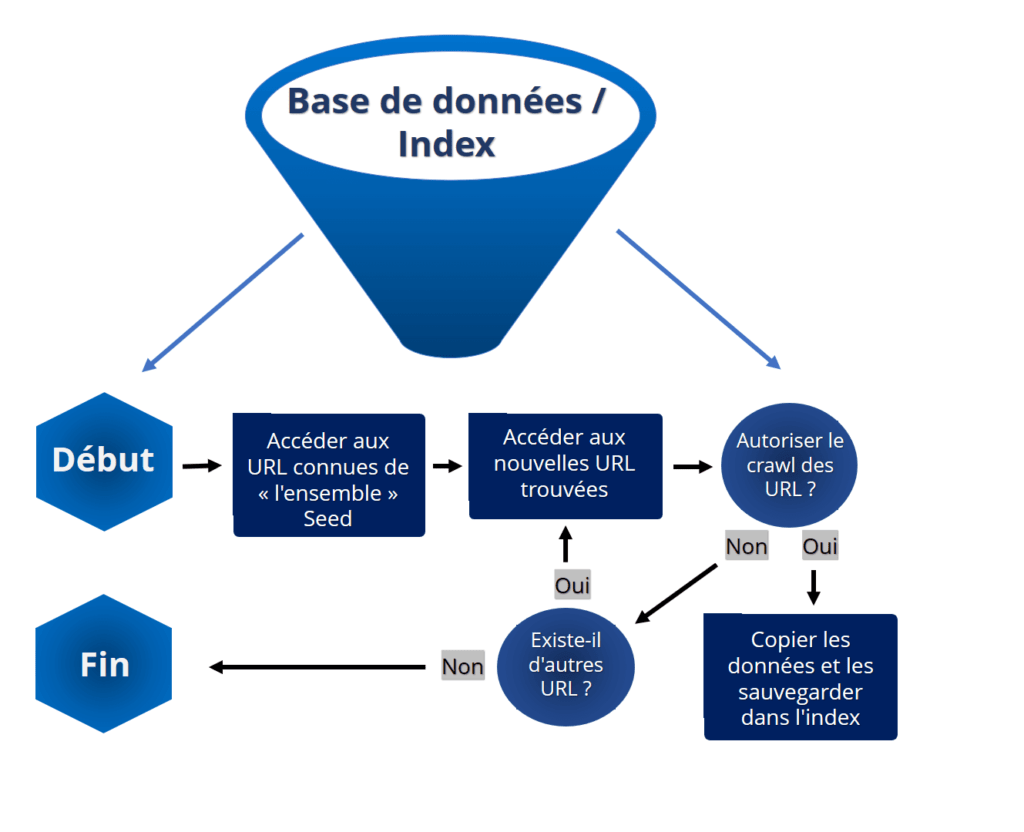

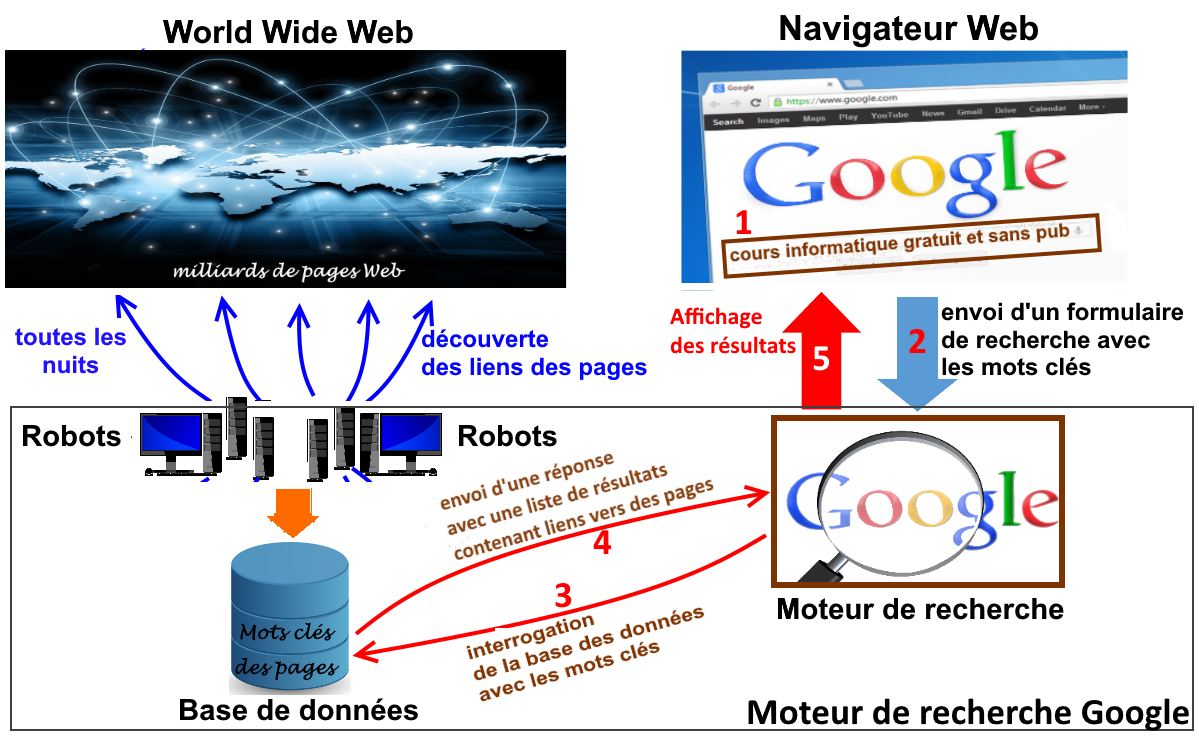

C'est assez simple, en fait. Ces robots commencent avec une liste de quelques pages web connues. Ces pages sont un peu comme leurs points de départ, leurs camps de base. Ensuite, ils font comme nous quand on surfe sur le web : ils cliquent sur les liens ! Chaque lien les mène à une nouvelle page, qu'ils ajoutent à leur liste de choses à analyser. Et ainsi de suite, de lien en lien, ils tissent une toile à travers tout le web. C'est un peu comme suivre une piste de miettes de pain, sauf que les miettes sont des liens hypertextes !

Voici un résumé de leur méthode:

- Départ d'une URL : Un robot commence son voyage avec une adresse web connue.

- Exploration : Il examine la page à la recherche de liens.

- Indexation : Il enregistre les informations importantes de la page (textes, images, vidéos, etc.).

- Suivi des liens : Il clique sur chaque lien et répète le processus pour chaque nouvelle page découverte.

- Mise à jour constante : Il revisite régulièrement les pages déjà indexées pour détecter les changements.

Pourquoi ils font ça ?

La réponse est simple : pour que les moteurs de recherche comme Google puissent vous donner des résultats pertinents quand vous faites une recherche. Sans ces robots, Google ne saurait pas que votre blog sur la cuisine moléculaire existe, ou que votre site web vend des chaussettes à motifs d'avocats (oui, ça existe !). En indexant le web, ces robots permettent aux moteurs de recherche de créer une sorte de carte géante de tout ce qui existe en ligne. C'est comme avoir un GPS pour l'internet !

Donc, la prochaine fois que vous trouvez exactement ce que vous cherchiez sur Google, pensez à ces petits robots infatigables qui ont travaillé en coulisses pour rendre ça possible. C'est grâce à eux que l'information est accessible en un clic !

Leur Impact sur Nous (et sur Nos Sites Web)

Ces robots d'indexation ont un impact énorme sur la visibilité de nos sites web. Si un robot ne trouve pas votre site, personne ne le trouvera non plus via un moteur de recherche. C'est un peu comme ouvrir un magasin dans une rue déserte : personne ne viendra vous voir !

Voici quelques points importants à considérer :

- Optimisation pour les moteurs de recherche (SEO) : Il est crucial d'optimiser votre site web pour que les robots puissent facilement le comprendre et l'indexer correctement. Cela implique d'avoir un site bien structuré, avec du contenu de qualité et des liens internes pertinents.

- Fichier robots.txt : Ce fichier permet de donner des instructions aux robots, par exemple, en leur indiquant quelles parties de votre site ils ne doivent pas explorer. C'est un peu comme mettre des barrières dans un labyrinthe pour guider les robots vers les zones les plus importantes.

- Sitemaps : Un sitemap est un fichier qui liste toutes les pages de votre site web. Il aide les robots à trouver et à indexer toutes vos pages plus rapidement. C'est comme donner une carte du trésor aux explorateurs !

- Vitesse de chargement : Les robots préfèrent les sites qui se chargent rapidement. Un site lent peut décourager les robots et nuire à votre référencement. Pensez à optimiser vos images et à utiliser un bon hébergement web.

Les défis des robots d'indexation

Même si ces robots sont incroyablement performants, ils ne sont pas parfaits. Ils font face à plusieurs défis :

- Le volume du web : Le web est immense et ne cesse de grandir. Indexer toutes les pages est un défi constant. Imaginez essayer de cartographier toutes les étoiles de l'univers !

- Les contenus dynamiques : De nombreuses pages web sont générées dynamiquement, ce qui signifie que leur contenu change en fonction des interactions de l'utilisateur. Les robots doivent être capables de comprendre ces contenus dynamiques pour les indexer correctement.

- Les formats variés : Les pages web peuvent contenir une grande variété de formats, comme des vidéos, des images, des fichiers audio, des documents PDF, etc. Les robots doivent être capables de traiter tous ces formats.

- Les contenus de mauvaise qualité : Malheureusement, le web est aussi rempli de contenus de mauvaise qualité, de spam et de fausses informations. Les robots doivent être capables de filtrer ces contenus pour ne pas les inclure dans l'index.

Le futur des robots d'indexation

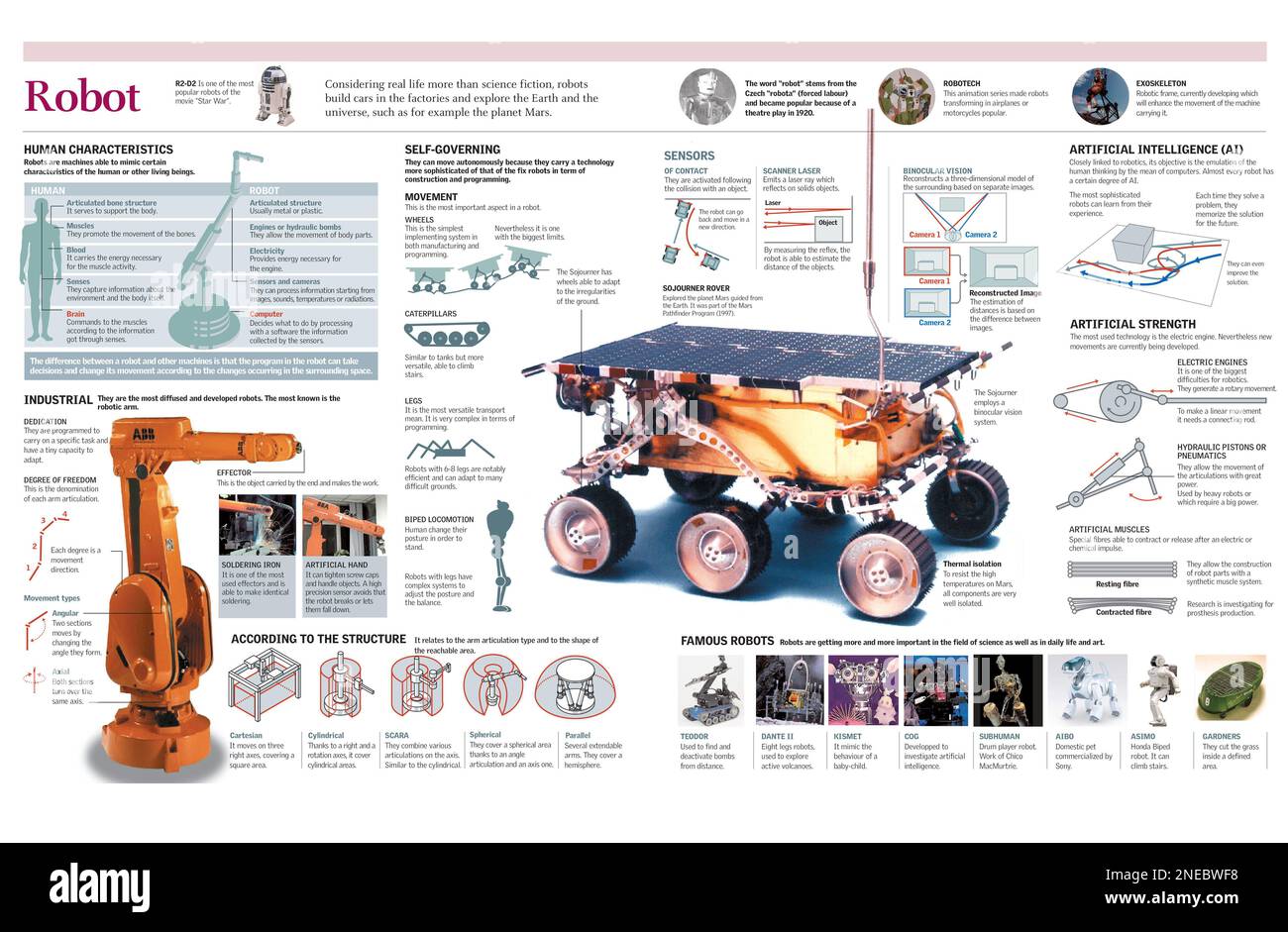

L'avenir des robots d'indexation s'annonce passionnant. On peut s'attendre à ce qu'ils deviennent encore plus intelligents et sophistiqués. Ils seront capables de comprendre le sens des pages web avec une plus grande précision, de détecter les contenus de mauvaise qualité avec plus d'efficacité et de s'adapter aux nouveaux formats et technologies.

Imaginez des robots capables de comprendre l'humour, de détecter le sarcasme, ou même de résumer le contenu d'un article en quelques phrases. C'est le genre de progrès qu'on peut espérer dans les années à venir ! La compréhension du langage naturel (NLP) et l'intelligence artificielle (IA) joueront un rôle crucial dans cette évolution.

Alors, la prochaine fois que vous utiliserez un moteur de recherche, n'oubliez pas de penser à ces petits robots infatigables qui travaillent sans relâche pour rendre l'information accessible à tous. Ils sont les héros méconnus du web ! Finalement, c'est pas juste une question de technologie, c'est une question d'accès à la connaissance et d'ouverture sur le monde. Et ça, c'est plutôt cool, non ?